https://webnautes.tistory.com/1247

음성인식, Google Cloud Speech-to-Text API 사용해보기

Cloud Speech API 서비스 계정 키를 발급받아서 샘플 코드를 실행하는 방법을 설명합니다. 마지막 업데이트 - 2018. 9. 20 1. Cloud Speech API 키 발급 받기 2. Cloud SDK 설치 3. 파이썬 예제 테스트 해보기 4...

webnautes.tistory.com

http://hleecaster.com/google-cloud-speech-to-text-api/

Google Speech-to-Text API를 활용해서 음성파일을 텍스트로 변환하자 (녹취록 받아적기 귀찮으니까) - �

파이썬과 구글 클라우드 speech-to-text API를 활용하여 녹취록을 스크립트로 변환해봤다. 긴(1분 이상) 오디오 파일 스크립트 작성 기능을 활용하는 예제를 첨부했다.

hleecaster.com

두 티스토리를 참고하여 진행.

Google colab을 이용하여 진행.

유의할 사항

1. 코랩에서 google-cloud-speech 설치

!pip install google-cloud-speech

2. 코랩에서 환경변수 설정

os.environ["GOOGLE_APPLICATION_CREDENTIALS"] = '/content/drive/My Drive/My First Project-8084512d8249.json'

3. timestamp저장하고 싶을 때

config에서 "enable_word_time_offsets": True로 설정해줘야 함

https://cloud.google.com/speech-to-text/docs/async-time-offsets?hl=ko

https://ebbnflow.tistory.com/153

[파이썬패키지] 자연어 처리를 위한 패키지3 - Gensim의 Word2Vec으로 토픽모델링

● Word2Vec 언어 모델링을 할 때, 언어(텍스트)를 신호 공간에 매핑(숫자로)하는 부분은 필수적입니다. 이러한 전처리를 단어 임베딩(Word Embedding)이라고 하는데 자연어 처리의 가장 기초적인 단계�

ebbnflow.tistory.com

'공부일지 > etc' 카테고리의 다른 글

| 파이썬 2차원 배열 정렬 (0) | 2020.10.12 |

|---|---|

| TextRank (0) | 2020.08.12 |

| 한국어 text generator만들어 보기 - konlpy 설치하기 (0) | 2020.07.22 |

| Pandas (0) | 2020.07.21 |

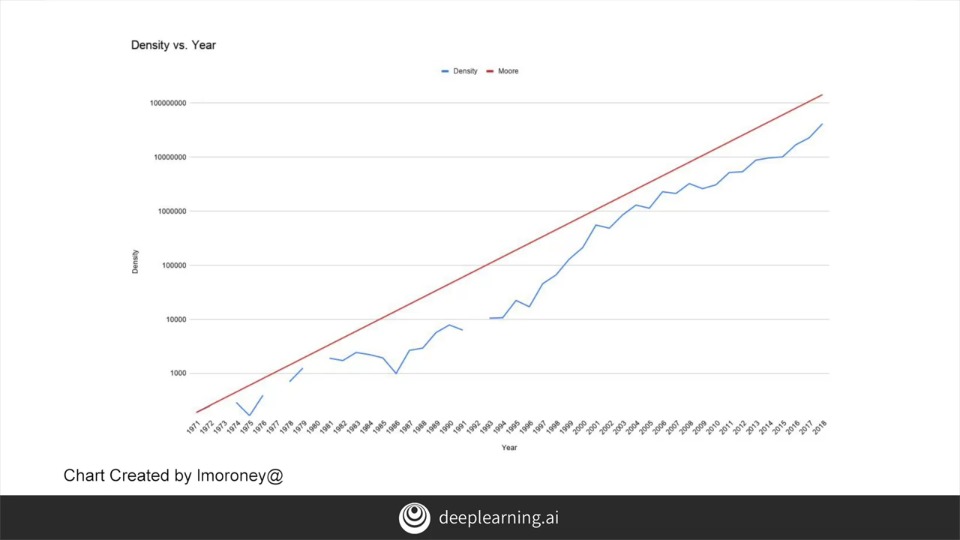

| Tensorflow in Practice 3, Sequence Model (0) | 2020.06.28 |